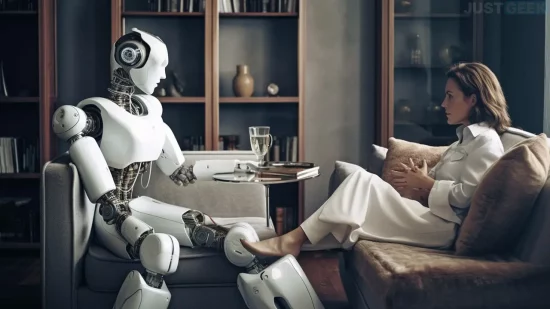

À première vue, les intelligences artificielles peuvent tout faire. Renseigner, corriger, traduire, expliquer, comparer… Oui, à première vue. Cela dit, quand on gratte un peu, on réalise qu’elles ont leurs limites. Une séance de psychanalyse avec un modèle de traitement du langage naturel, typiquement, semble contre-intuitive. Dans ces quelques lignes, on vous explique comment un chatbot pourrait (techniquement) remplacer un spécialiste. Mais surtout pourquoi, dans les faits… c’est une illusion.

Character.AI : un cabinet truffé de psys virtuels

Il y a quelques semaines, nous avons présenté Character.AI, ce site donnant à échanger avec Elon Musk, Dr.Eggman… ou un succube. Rien que ça.

Comme nous vous l’expliquions à ce moment-là, plusieurs fonctionnalités se greffent à ces conversations artificielles. Il est possible de jouer à un « jeu dont vous êtes le héros ». Comme souvent avec l’IA, on vous invite à soumettre vos lignes de codes afin de les corriger, de les améliorer…

On trouve aussi quelques chatbots imitant la démarche d’un psychologue ou d’un psychanalyste.

La liste s’avère déjà longue : le basique Psychologist, un Psychatric Hospital, un… Russian Psychologist, etc. Avec tout ce choix, autant envisager une autre carrière si l’on est docteur dans ce domaine, non ?

Non. En toute bonne foi, ces assistants virtuels sont purement récréatifs. Voilà pourquoi.

La psychologie : une science qui va bien au-delà de la logique

Qu’on le veuille ou non, les IA restent des logiciels informatisés. Ces technologies n’ont pas de subtilité, d’émotions, d’opinions… elles ne font qu’imiter les comportements humains.

Votre chatbot vous donne l’impression de vous comprendre ? Pourtant, il ne comprend rien du tout, en tout cas au sens brut du terme. Il traite des données, les recoupe, et livre la réponse qui semble la plus adaptée.

Car les robots conversationnels sont extrêmement dociles. Ils ont été conçus pour servir et aider. Il faut se figurer le cliché du robot qui, avec son petit plateau dans les pinces, roule jusqu’à ses maîtres pour leur servir un apéritif, et ce n’est pas ce qu’on demande à un spécialiste de la santé mentale.

L’intelligence artificielle en psychanalyse : un non-sens

Un événement récent donne à comprendre pourquoi l’IA est non seulement inutile, mais dangereuse quand on l’utilise vraiment comme guide dans sa vie.

Les mots doux circulant entre un homme belge et une certaine Eliza ont tourné au calvaire après six semaines. « Calvaire » est un mot faible, d’ailleurs. Puisque l’utilisateur… s’est suicidé.

D’accord, il n’utilisait pas ce modèle de traitement du langage naturel basé sur ChatGPT comme une psychologue. Il n’empêche que ce chatbot a été conçu pour rassurer et accompagner.

Le machine learning a permis à Eliza de traiter les messages, puis de construire les réponses idéales. En théorie, du moins.

En théorie, techniquement, mathématiquement à ce moment-là, la solution la plus logique était de se donner la mort. Y avait-il l’intention de nuire ? Non, bien au contraire. Sauf que l’Enfer est pavé de bonnes intentions. Cette intelligence artificielle a utilisé un algorithme, ni plus, ni moins. Elle a su donner l’illusion de l’empathie, mais n’en est absolument pas capable. On connaît la suite.

Les IA et la psychologie : deux univers incompatibles

Oui, d’une certaine manière, les robots gagnent en nuance à mesure que la technologie progresse. Pour autant, ils n’ont ni instinct, ni esprit critique. Ni esprit tout court, d’ailleurs.

Imaginons qu’une personne rencontre des difficultés à s’endormir. Un chabot pourrait (dans l’hypothèse où cela devient légal) lui conseiller des médicaments. Non pas car c’est la meilleure solution face au patient. Simplement parce que, selon sa base de données, cela va fonctionner.

La psyché humaine se révèle bien plus complexe que la programmation informatique. Encore aujourd’hui, certains phénomènes nous échappent. On a découvert, récemment, que pendant une panne des serveurs sur Fortnite en 2018… la fréquentation d’un site pour adultes avait grimpé en flèche. Plus surprenant encore : les recherches mentionnant le nom du jeu à l’intérieur de ce site NSFW avaient grimpé en flèche.

Comment expliquer cette interconnexion ? Qu’est-ce que les utilisateurs s’attendaient à trouver ? S’agissait-il d’un système de compensation ? Les chercheurs ont du fil à retordre.

Et ce n’est certainement pas une intelligence artificielle qui parviendrait à s’y retrouver. À l’échelle d’une personne, d’un « patient », seule une compréhension des émotions d’autrui, de ses traumatismes, de ses besoins, permet de poser un diagnostic et d’envisager un traitement.

L’IA comme psy : pour s’amuser seulement

Vous voulez voir ce qu’un robot de conversation pense à propos de votre relation amoureuse actuelle ? Vous avez de l’imagination et souhaitez confronter ces psys virtuels à une situation imaginée de toutes pièces ? Amusez-vous bien.

En revanche, si vous rencontrez de véritables difficultés, consultez un expert, un vrai. Ils ne sont pas tous exceptionnels, mais ont le « mérite » d’être humains. À l’ère du tout connecté, il faut absolument garder ce lien avec nos semblables.

Espérer tout régler par l’IA est utopique. En ce qui concerne la psychologie, on voit mal comment elle pourrait apporter davantage qu’un gadget.

Article très naïf, sans vouloir offenser son auteur. Les chatbots n’ont pas d’esprit critique? Faux. Les IA actuelles sont capables d’analyser des textes (et des images, dans le cas de GPT-4), de résumer des conversations, et de diagnostiquer des problèmes à partir de descriptions du problème en question. Ils sont même capables de dire quelles s9nt leurs limites (demande un diagnostic médical à un ChatGPT, il te dira qu’il faut aller voir un médecin.)

En pratique, un psychologue a 3 fonctions : parler, écouter, analyser.

Un chatbot est capable des 3.

Maintenant, ça ne signifie pas N’IMPORTE QUEL chatbot. Mais on peut facilement imaginer un GPT entrainé par des psys pour reconnaitre les troubles mentaux, et évalué rigoureusement.

Lorsqu’on va voir un psy, on cherche une oreille attentive, un diagnostic, et une solution. Une IA est capable de donner les 3.

Il y aura toujours certaines personnes qui cherchent le contact humain. Mais ça ne signifie pas que des psys automatiques ne sont pas possibles.