OpenAI continue de peaufiner ses modèles de langage, et le dernier en date vient d’être lancé : o3-pro. Disponible dès maintenant pour les abonnés Pro et Team de ChatGPT, ce nouveau modèle remplace o1-pro dans le sélecteur. Ce n’est plus simplement une « version » d’o3 : il s’agit d’un modèle qui « réfléchit plus longtemps », au sens propre, pour produire des réponses plus fiables, mieux construites, et globalement préférées par les utilisateurs dans la plupart des cas.

Plus performant en maths, en sciences, en rédaction ou encore en programmation, o3-pro ne se contente pas de promesses : les chiffres sont là pour le prouver. En revanche, cette montée en puissance a un petit coût côté réactivité, OpenAI prévenant que les réponses du modèle peuvent parfois mettre un peu plus de temps à arriver. Rien de dramatique, mais on est prévenu.

Des réponses plus convaincantes dans tous les domaines

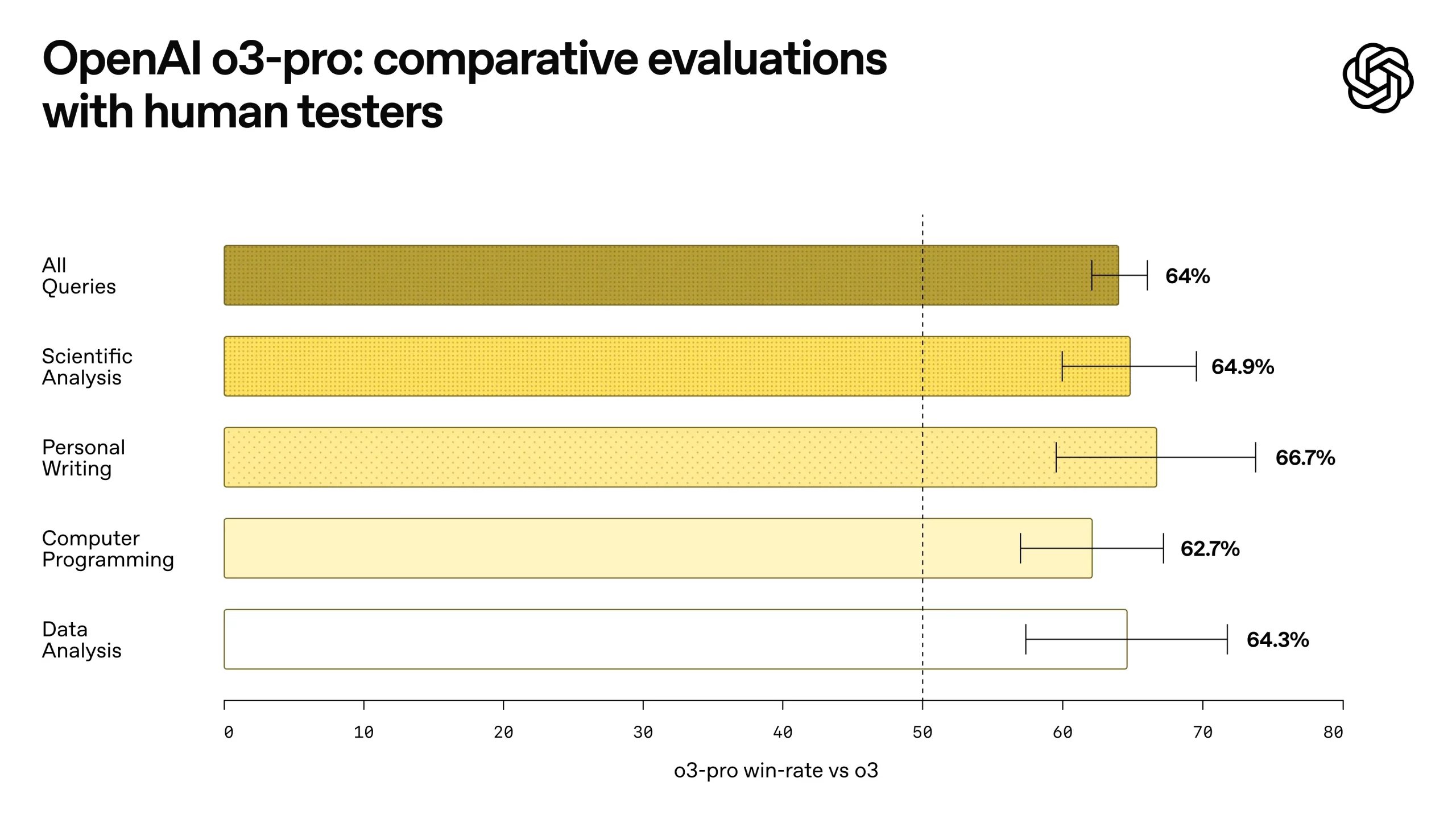

Pour évaluer les progrès d’o3-pro, OpenAI a mené une série de tests avec des évaluateurs humains. Le modèle a été comparé directement à o3, et dans près de 64 % des cas, c’est o3-pro qui a été préféré. Ce taux grimpe même à 66,7 % lorsqu’il s’agit de rédaction personnelle, ou encore 64,9 % pour l’analyse scientifique. Même constat en programmation ou en analyse de données, avec des écarts significatifs en faveur d’o3-pro.

Voici les résultats détaillés de cette évaluation comparative :

Ce graphique montre clairement que, quel que soit le type de requête, o3-pro tire son épingle du jeu. Les testeurs ont jugé ses réponses plus claires, plus complètes et surtout mieux alignées avec les consignes données.

Des scores impressionnants face à Gemini et Claude

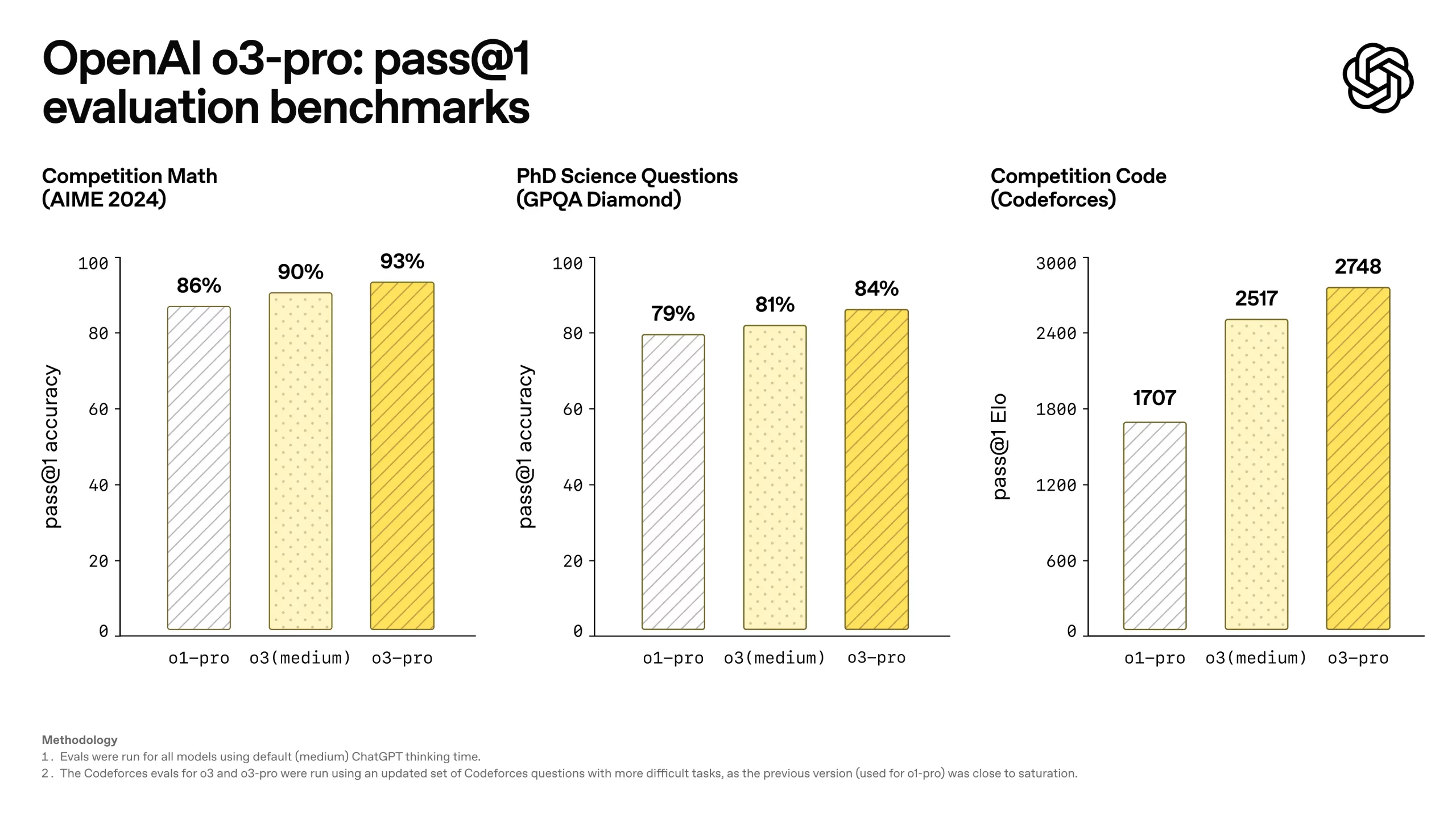

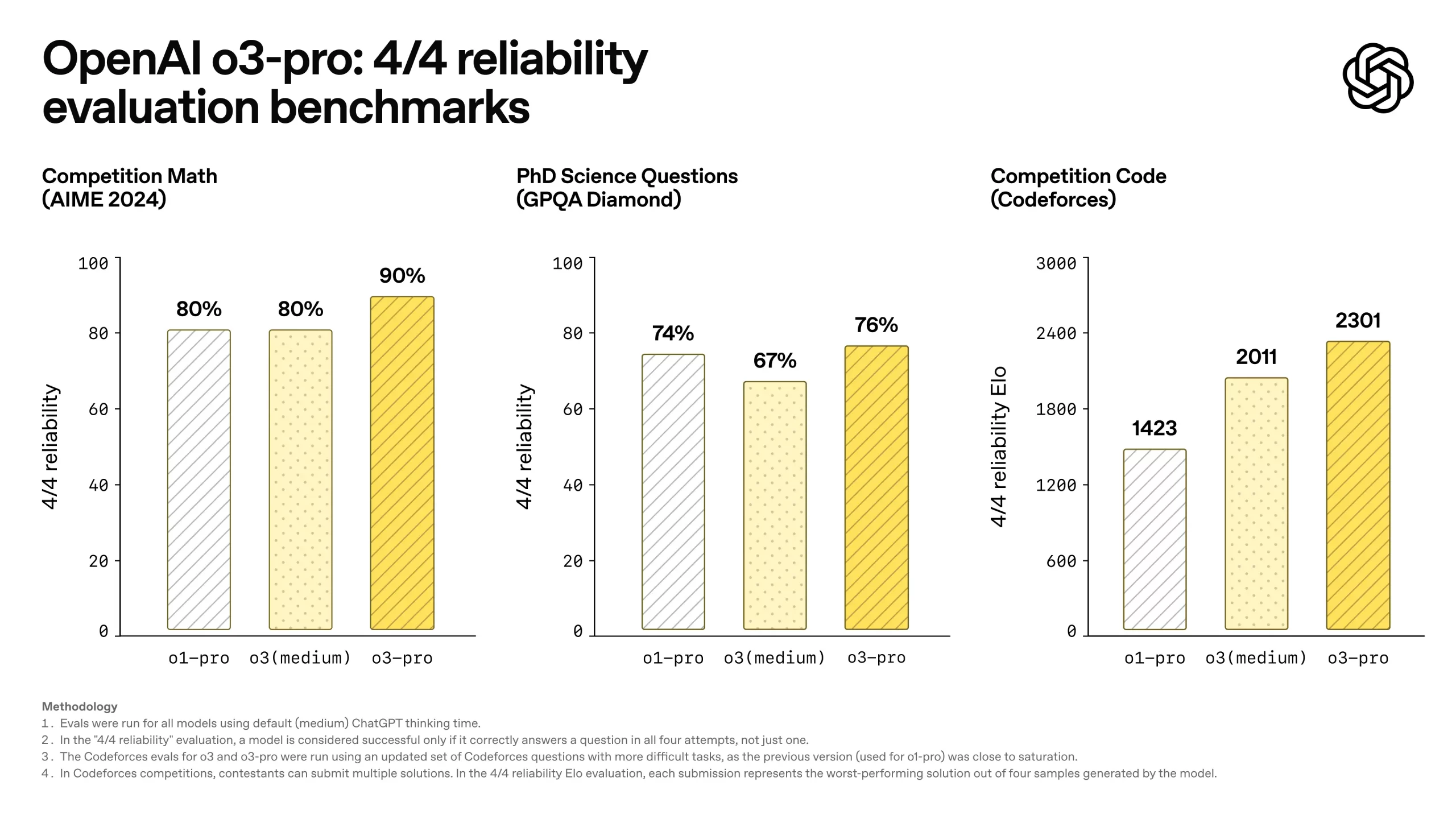

Au-delà des préférences subjectives des testeurs, OpenAI met aussi en avant des benchmarks concrets pour appuyer les performances de son modèle. Sur AIME 2024, un test réputé dans le domaine des mathématiques, o3-pro fait mieux que Gemini 2.5 Pro de Google. Et sur GPQA Diamond, un benchmark de connaissances scientifiques de niveau doctorat, il dépasse Claude 4 Opus, le dernier modèle haut de gamme d’Anthropic.

Ces résultats positionnent clairement o3-pro comme l’un des modèles les plus performants à l’heure actuelle, notamment dans les domaines complexes où la logique et la rigueur sont de mise.

Un accès complet aux outils, mais pas à tout

Comme o3, le modèle o3-pro peut accéder à l’ensemble des outils intégrés de ChatGPT. Cela signifie qu’il est capable de :

- faire des recherches sur Internet,

- analyser des fichiers (PDF, Word, etc.),

- interpréter des images ou des graphiques,

- exécuter du code Python pour résoudre des problèmes complexes,

- et même personnaliser ses réponses grâce à la mémoire (si elle est activée dans votre compte).

Bref, tout est là pour traiter des requêtes avancées, qu’il s’agisse d’un besoin technique, scolaire ou professionnel. C’est d’ailleurs cette combinaison de puissance de raisonnement et de polyvalence qui fait d’o3-pro un modèle à part.

⚠️ Mais attention, tout n’est pas encore au rendez-vous. Voici ce qu’o3-pro ne prend pas en charge pour le moment :

- la génération d’images (utilisez plutôt GPT-4o, o3 ou o4-mini pour ça),

- les conversations temporaires, désactivées temporairement à cause d’un bug,

- l’interface Canvas, toujours incompatible avec ce modèle.

Une montée en gamme logique (et stratégique)

Avec o3-pro, OpenAI ne réinvente pas la roue, mais affine son modèle de langage le plus performant à ce jour. Les améliorations sont nettes, autant sur le fond que sur la forme. Et même si les réponses prennent parfois quelques secondes (ou minutes) de plus, on gagne largement en fiabilité et en précision.

Le modèle est déjà disponible dans ChatGPT pour les abonnés Pro et Team, et sera accessible dans les jours à venir pour les utilisateurs Enterprise et Edu. Les développeurs peuvent également l’utiliser via l’API, avec un tarif de 20 $ pour un million de tokens en entrée, et 80 $ en sortie. Il dispose d’une fenêtre contextuelle de 200 000 tokens, de quoi gérer des prompts bien plus longs que la moyenne.

Source : TechCrunch, OpenAI